目标

- 训练性能

- 资源占用

- 模型效果

baseline

训练性能

- IO:缓存,pipeline,并行处理,数据存储方式(稀疏化存储)

- 计算:超参调整(batch-size),优化器选择,梯度更新方式,稀疏表示运算,线程数量调整(线程太多,切换代价高)

资源占用

流式读取训练数据

buffer size

优化器

模型编写方式

模型效果

- 模型结构

- 优化器

- 超参

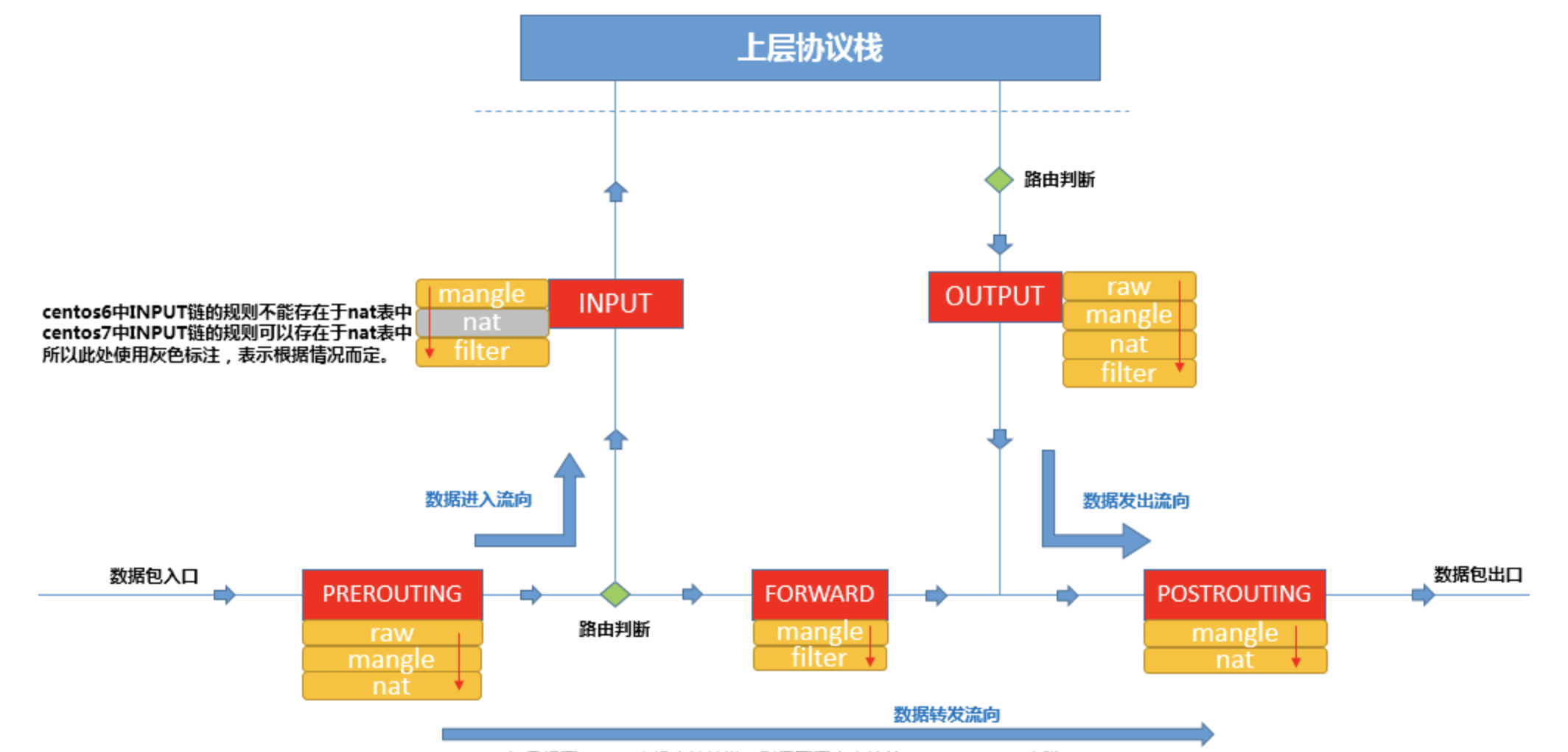

分布式

阿姆达尔定律评估加速上限,提供理论指导。

尽量提高计算访存比。

训练性能

分布式模式选择:AllReduce vs PS

数据切分方式:文件名切分

梯度合并方式:提高计算/通信比。提高并发,降低延迟

PS模式下,大tensor切分

Horovod模式下,梯度融合传递

调度策略(bin-pack, spread)

模型效果

- 超参调整:lr

高级话题

- 特征动态增删(Dynamic embedding)

- 实时训练

- 可伸缩分布式训练(elasticDL,FTlib)